掌握robots.txt文件:全面使用指南

- 更新时间:2024-11-19

robot.txt文件的详细使用教程

在网站的SEO和内容管理中,robot.txt文件扮演着举足轻重的角色。它是网站与搜索引擎爬虫之间的“交通规则”,指导着哪些页面可以被访问,哪些应该被忽略。正确使用robot.txt文件,不仅能保护网站敏感数据,还能优化爬虫效率,从而提升网站的整体性能。以下,我们将从robot.txt的基本概念、创建与编辑、常见指令、最佳实践等多个维度,详细阐述其使用方法。

一、robot.txt的基本概念

robot.txt文件,全称robots exclusion protocol(机器人排除协议),是一个放在网站根目录下的纯文本文件。该文件使用特定的语法规则,明确告诉搜索引擎爬虫哪些目录、页面或内容是不希望被访问或索引的。值得注意的是,虽然名为“机器人”,但robot.txt的指令不仅适用于搜索引擎爬虫,理论上任何遵守该协议的自动化程序都会遵循其规则。

二、创建与编辑robot.txt文件

1. 创建robot.txt文件

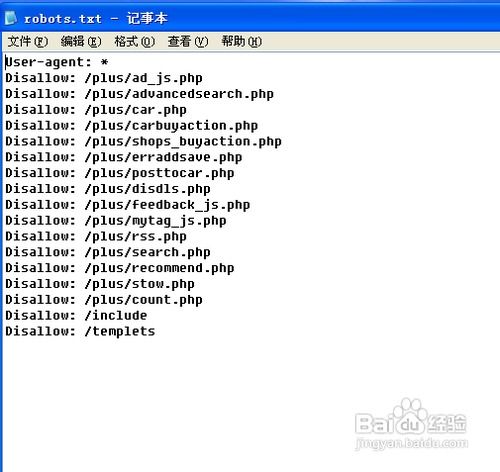

创建robot.txt文件非常简单,只需使用任何文本编辑器(如记事本、Notepad、VS Code等)新建一个文件,并将文件名命名为“robot.txt”(注意没有扩展名)。然后将编写好的指令内容复制粘贴到文件中,保存至网站的根目录下(即域名直接访问的顶级目录)。

2. 编辑robot.txt文件

编辑robot.txt文件同样便捷,只需通过FTP客户端(如FileZilla)、网站后台的文件管理器或SSH等方式连接到网站服务器,找到根目录下的robot.txt文件,用文本编辑器打开进行修改,保存后上传覆盖原文件即可。

三、robot.txt的常见指令

robot.txt文件的指令主要由User-agent、Disallow和Allow三部分组成,通过不同的组合和设置,可以灵活地控制爬虫行为。

1. User-agent

User-agent指令用于指定以下规则适用于哪些爬虫。常见的User-agent值包括:

`*`:代表所有爬虫。

`Googlebot`:谷歌搜索引擎爬虫。

`Bingbot`:必应搜索引擎爬虫。

`Baiduspider`:百度搜索引擎爬虫。

例如,`User-agent: *`表示以下规则适用于所有爬虫。

2. Disallow

Disallow指令用于指定不希望被爬虫访问的路径。可以是完整的URL路径,也可以是路径的一部分。如果路径以斜杠(/)开头,则表示从根目录开始的路径;如果以星号(*)结尾,则表示匹配该路径下所有文件和子目录。

例如,`Disallow: /private/`表示禁止访问/private/目录及其下的所有内容。

3. Allow

Allow指令用于指定允许爬虫访问的路径,通常与Disallow指令结合使用,以提供更细粒度的控制。如果User-agent下既有Allow又有Disallow指令,且两者之间存在冲突,通常Allow指令具有更高的优先级(但不同爬虫的实现可能有所不同,因此建议明确规则,避免歧义)。

例如,`Allow: /public/` 和 `Disallow: /*`组合使用,意味着允许访问/public/目录,但禁止访问网站其他所有内容。然而,这种组合较为罕见,因为直接`Allow: /public/`在`User-agent: * Disallow: /*`的全局禁止规则下并不生效,除非在更具体的User-agent分组中定义。更常见的做法是在全局允许的基础上,使用Disallow排除特定路径。

四、robot.txt的最佳实践

1. 明确规则,避免歧义

编写robot.txt时,应确保规则清晰明确,避免使用可能引起歧义的写法。例如,尽量避免在同一User-agent下混合使用Allow和Disallow指令,除非完全了解它们的优先级关系。同时,对于复杂路径,应使用完整的URL路径进行定义,以减少误解。

2. 谨慎使用全局禁止

全局禁止(如`User-agent: * Disallow: /`)将阻止所有爬虫访问网站的所有内容,这通常不是一个好的做法。除非网站处于建设初期或维护状态,不希望被搜索引擎索引,否则应至少允许访问网站的首页和sitemap.xml文件,以便搜索引擎爬虫能够发现和索引网站的重要页面。

3. 定期检查和更新

随着网站内容的增加和结构的调整,robot.txt文件也需要定期检查和更新。确保规则与网站的实际需求保持一致,避免因规则过时而导致重要页面被误屏蔽。

4. 注意敏感信息保护

虽然robot.txt文件可以阻止搜索引擎爬虫访问某些路径,但它并不提供真正的安全防护。敏感信息(如用户数据、配置文件等)应通过服务器配置(如.htaccess文件、Nginx/Apache配置)进行保护,而不是依赖robot.txt文件。

5. 使用sitemap文件配合

sitemap文件(sitemap.xml)是网站所有页面的清单,可以帮助搜索引擎爬虫更有效地发现和索引网站内容。将sitemap文件的URL添加到robot.txt文件中(如`Sitemap: http://www.example.com/sitemap.xml`),可以引导爬虫更高效地遍历网站。

6. 测试与验证

在发布新的robot.txt文件之前,应使用在线工具或爬虫模拟软件对其进行测试,确保规则按预期工作。同时,可以检查搜索引擎的爬虫访问日志,以验证robot.txt文件是否已被正确读取和执行。

五、结语

robot.txt文件是网站SEO和内容管理中的重要组成部分,通过合理的设置,可以实现对搜索引擎爬虫的有效控制。然而,它并非万能的解决方案,需要结合其他安全措施和SEO策略共同发挥作用。因此,在使用robot.txt文件时,应充分考虑网站的实际需求,遵循最佳实践,以确保其发挥最大的效用。

- 上一篇: Excel公式中的加减乘除运算

- 下一篇: 如何让WiFi密码设置得更安全,防止被蹭网?